Tất cả chúng ta đang đều sống và làm việc trong thời đại công nghệ hiện đại nó đang làm thay đổi toàn bộ cục diện của tất cả hầu hết các lĩnh vực kinh tế, xã hội, y tế, quốc phòng,..

Xem thêm: BIG DATA – THÀNH QUẢ CỦA CÁCH MẠNG CÔNG NGHỆ HIỆN ĐẠI

Tất cả chúng ta đang đều sống và làm việc trong thời đại công nghệ hiện đại nó đang làm thay đổi toàn bộ cục diện của tất cả hầu hết các lĩnh vực kinh tế, xã hội, y tế, quốc phòng,..

Xem thêm: BIG DATA – THÀNH QUẢ CỦA CÁCH MẠNG CÔNG NGHỆ HIỆN ĐẠI

Hàn Quốc tự hào là nước có ngân hàng dữ liệu quốc gia về sức khoẻ của toàn bộ người dân. Hiện nay, Hàn Quốc đã bắt đầu nghiên cứu ứng dụng “Y học chính xác” hay “Y học cá thể” từ kho dữ liệu lớn về sức khoẻ của quốc gia. Tại quốc gia này, dữ liệu sức khoẻ của người dân được chia làm 6 nhóm dữ liệu.

Dữ liệu gen và SDOH là đầu vào của tình trạng sức khỏe, dữ liệu lâm sàng và PGHD là đầu ra của tình trạng sức khỏe

Xem thêm: Tìm hiểu các loại dữ liệu sức khoẻ của “Big data” tại Hàn Quốc

Giới thiệu về K – nearest neighbor (KNN)

Ở các bài viết trước đã giới thiệu đến các bạn một cách tổng quan những chủ đề về Data mining (Khai phá dữ liệu), Predictive analytics (Phân tích dự báo), Statistics (Thống kê) bao gồm các khái niệm quan trọng, kỹ thuật phân tích và ứng dụng, lợi ích trong các lĩnh vực khác nhau.

Xem thêm: THUẬT TOÁN KNN VÀ VÍ DỤ ĐƠN GIẢN TRONG NGÀNH NGÂN HÀNG

Phân tích dự báo hay còn gọi Predictive analytics là một trong những phương pháp, kỹ thuật phân tích dữ liệu phổ biến và quan trọng nhất ngày nay. Đây là công cụ hữu ích để những nhà khoa học, chuyên gia hoạt động ở lĩnh vực Data science có cái nhìn chi tiết về đối tượng nghiên cứu, khám phá các mối liên hệ, đưa ra những phán đoán về đối tượng nghiên cứu ở tương lai chứ không chỉ dừng lại tại quá trình mô tả.

Xem thêm: TỔNG QUAN VỀ PREDICTIVE ANALYTICS (PHÂN TÍCH DỰ BÁO) (PHẦN 1)

Ngành công nghiệp du lịch và lữ hành đang đối mặt với thách thức bán đúng sản phẩm đến đúng đối tượng khách hàng vào thời điểm chính xác và giữ đúng giá ở đúng kênh. Tất cả điều này đòi hỏi dữ liệu nội bộ lẫn bên ngoài. Dữ liệu nội bộ như kỳ vọng của khách hàng trong quá khứ, tỷ lệ hết vé, doanh thu phòng và tình trạng đặt vé hiện tại. Dữ liệu bên ngoài gồm sự kiện, thời tiết, những chuyến bay và những kỳ nghỉ.

Nếu các bạn có theo dõi các bài viết trước của Big Data Uni về Chatbot thì cũng đã biết sự cần thiết và tầm quan trọng của hệ thống trả lời tự động ứng dụng trong mọi lĩnh vực, với mục đích quản lý hiệu quả các hoạt động tạo dựng, duy trì mối quan hệ với khách hàng đồng thời thu hút họ mua sản phẩm và đăng ký sử dụng dịch vụ.

Nguồn tài nguyên giá trị nhất của thế giới hiện nay không còn là dầu mỏ, mà là kho dữ liệu số đang tăng lên với cấp độ lũy thừa mỗi ngày. Trong cuộc cách mạng công nghiệp 4.0, Big Data là một yếu tố đóng vai trò then chốt. Vậy Big Data thực chất là gì, và nó đang được ứng dụng như thế nào? Đối với nhiều người, đó là một thuật ngữ mơ hồ về hình ảnh của những hệ thống máy chủ khổng lồ, hoặc sẽ liên hệ đến việc nhận được các loại quảng cáo từ một nhà bán lẻ.

Hiện nay dữ liệu lớn (big data) và khoa học dữ liệu là một lĩnh vực rất sôi nỗi và phát triễn nhanh trong thời gian gần đây. Như đánh giá của Trường Đại Học Harvard, Hoa Kỳ thì nhà khoa học dữ liệu (data scientist) sẽ là công việc hấp dẫn nhất thế kỹ 21.

Như ta đã biết, hệ thống phân tích kinh doanh thông minh (BI) không chỉ là phần mềm. Để triển khai thành công hệ thống BI, doanh nghiệp cần phải có quy trình và cơ sở hạ tầng tốt bên cạnh việc lựa chọn đúng úng dụng phân tích kinh doanh thông minh (BI tools).

Xem thêm: Cách tốt nhất để thành công với hệ thống phân tích kinh doanh – BI (Business Intelligence)

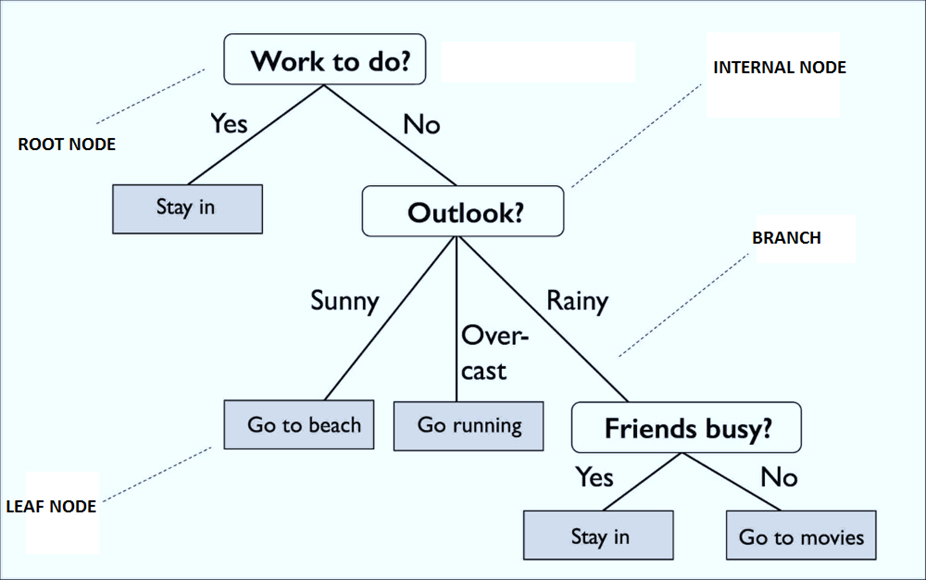

Trở lại với chủ đề về các thuật toán cây quyết định Decision trees, như vậy qua các bài viết trước chúng ta đã tìm hiểu về tổng quan thuật toán cây quyết định là gì, làm quen với các dạng thuật toán CART (phân 2 nhánh) sử dụng công thức Goodness of Split, Gini Index và C4.5 (phân nhiều hơn 2 nhánh) sử dụng công thức Entropy kết hợp với Information gain.

Xem thêm: THUẬT TOÁN CÂY QUYẾT ĐỊNH (P.4): ƯU & KHUYẾT ĐIỂM, STOPPING & PRUNING METHOD

Giá trị khách hàng suốt vòng đời – Customer lifetime value

Một trong những khái niệm mà bất kể chuyên gia tiếp thị marketing hay chủ doanh nghiệp cần để ý là giá trị của khách hàng trong suốt vòng đời của họ. Điều này đặc biệt quan trọng khi đề ra chiến lượt tiếp thị marketing, định vị thương hiệu của mỗi nhãn hàng ( brand).Cụ thể hơn là khi đưa ra quyết định, tính toán về chi phí quảng cáo marketing cho mỗi khách hàng và ngân sách cho các chiến dịch tiếp thị marketing.

Xem thêm: Giá trị suốt vòng đời của khách hàng – Customer lifetime value

Xem thêm: Dịch vụ và giải pháp Big Data cho lĩnh vực Y - Dược - Chăm Sóc Sức Khỏe

Thông thường, khi khối lượng của một tập dữ liệu rất lớn và không thể quản lý được như các cơ sở dữ liệu truyền thống, thì chúng ta có thể gọi nó là Big Data. Đến lúc này, đám mây cung cấp cơ sở hạ tầng cần thiết cho việc tính toán dữ liệu lớn. Trong cuộc sống thực, nhiều tổ chức đang kết hợp hai công nghệ này để cải thiện hoạt động điều phối kinh doanh của mình.

Một dự án lớn đang được tiến hành ở cả Anh và Mỹ nhằm thu thập thông tin thông qua một khối lượng lớn dữ liệu bệnh nhân. Đây là một dự án đầy hứa hẹn nhằm tối ưu hóa giá trị sử dụng thuốc, từ việc xác định sự kém tuân thủ trong điều trị để nâng cao chất lượng kê đơn.

Big Data mang lại cơ hội cho lĩnh vực bán lẻ bằng cách phân tích thị trường cạnh tranh và sự quan tâm của khách hàng. Nó giúp xác định hành trình trải nghiệm, xu hướng mua sắm và sự hài lòng của khách hàng bằng cách thu thập dữ liệu đa dạng.

Để thu thập các thông tin bệnh nhân các nhà nghiên cứu phải sử dụng đến đơn vị petabyte. Mỗi petabyte dữ liệu tương đương với 1 triệu gigabyte. Công ty Express Scripts, có trụ sở tại St Louis, Missouri, Mỹ, đã thu thập được 22 petabyte dữ liệu y tế từ 83 triệu bệnh nhân, với số lượng dữ liệu này được chuyển đổi thành định dạng MP3, sẽ mất khoảng 44.000 năm để lắng nghe hết số lượng tệp nhạc này.

Xem thêm: Sự ảnh hưởng của “Big data” tới ngành Dược trong tương lai

Thương mại điện tử không chỉ tận hưởng những lợi ích của việc điều hành trực tuyến mà còn phải đối mặt với nhiều thách thức để đạt được các mục tiêu kinh doanh. Lý do là bởi các doanh nghiệp dù là nhỏ hay lớn, khi đã tham gia vào thị trường này đều cần đầu tư mạnh để cải tiến công nghệ.

Big Data ngày càng được sử dụng để tối ưu hóa các quy trình kinh doanh. Các nhà bán lẻ có thể tối ưu hóa cổ phiếu của họ dựa trên dự đoán. Từ dữ liệu truyền thông xã hội, xu hướng tìm kiếm trên web và dự báo thời tiết.

Xem thêm: Giải Pháp Big Data Tối ưu hóa quy trình kinh doanh

Trở lại với chủ đề về các xu hướng Big Data sẽ đi đầu trong năm 2019, ở phần 1, Big Data Uni đã đề cập về sự phát triển và thay đổi của Internet of Things (IOT), trí tuệ nhân tạo (Artificial Intelligence – AI), Machine Learning (ML) tác động như thế nào đến lĩnh vực Big Data, và một số dự báo về thị trường Big Data. Phần 2 bài viết, chúng tôi sẽ đề cập chi tiết về các xu hướng của những công cụ, cách thức hỗ trợ cho việc khai thác, tiếp cận Big Data, cùng với các vấn đề, thách thức mới trong lĩnh vực Big Data.

Xem thêm: TOP CÁC XU HƯỚNG BIG DATA SẼ ĐI ĐẦU TRONG NĂM 2019 (PHẦN 2)

Khoa học phân tích dữ liệu là một nhánh rẽ quan trọng trong lĩnh vực công nghệ thông tin. Nó sớm bộc lộ những tiềm lực quan trọng thúc đẩy sự phát triển của thế giới. Với sự phát triển nhanh chóng và lan rộng của mình, ngành Khoa học Dữ liệu đặc biệt thu hút sự quan tâm của các chuyên gia Việt Nam và cả trên khắp thế giới.

Xem thêm: Khoa học phân tích dữ liệu – Góc nhìn từ Việt Nam và Thế Giới

Ngày nay, tiềm năng phát triển các chiến lược kinh doanh dựa trên dữ liệu và thông tin là lớn hơn bao giờ hết. Đối với một số tổ chức, dữ liệu và phân tích dữ liệu đã trở thành động lực chính trong việc đề xuất các chiến lược kinh doanh của họ.

Xem thêm: CÔNG TY ĐỊNH HƯỚNG DỮ LIỆU (DATA – DRIVEN ENTERPRISE) (PHẦN 2)

Ở bài viết trước, chúng tôi đã giới thiệu sơ lược về Chatbot về khái niệm cũng như cách thức vận hành đơn giản nhất của Chatbot. Lần này, chúng tôi sẽ cung cấp cho các bạn về các phương pháp, thuật toán là cơ sở hoạt động của Chatbot hay nói cách khác Chatbot hoạt động ra sao?

Xem thêm: TỔNG QUAN VỀ CHATBOT (PHẦN 2): CHATBOT HOẠT ĐỘNG NHƯ THẾ NÀO?

Bạn có biết là những vị trí liên quan tới lĩnh vực khoa học dữ liệu (data science) và phân tích dữ liệu (data analysis) là khó tuyển nhất với một công ty không? Sự bùng nổ nhu cầu tìm kiếm các chuyên gia trong những lĩnh vực này mở ra hàng loạt nhu cầu và đồng thời, đẩy thị trường tuyển dụng vào tình trạng cung không đủ đáp ứng cầu.

Business Intelligenc (BI) hay Data Analytics – phân tích dữ liệu từ lâu đã trở thành các công cụ hữu ích hỗ trợ các tổ chức, công ty trong quá trình hoạt động và phát triển. Ở bài viết lần này, sẽ giới thiệu đến các bạn các lợi ích của phân tích dữ liệu trong kinh doanh, nhưng trước tiên ta cùng phân biệt rõ 2 khái niệm được nêu ở trên mà nhiều người thường nhầm lẫn.

Ngoài ra chúng tôi còn có sẵn data địa điểm rất hữu ích cho các dự án khởi nghiệp về du lịch, địa điểm, mạng xã hội du lịch, ...

Xem thêm: Dịch vụ và giải pháp Big Data cho lĩnh vực du lịch

Ở 2 bài viết trước đã giới thiệu đến các bạn thuật toán Classification đầu tiên là KNN (K – nearest neighbor) và một số phương pháp đánh giá mô hình phân loại như Hold out, Cross validation, hay Confusion matrix, Lift, Gain chart, ROC/ AUC. Trở lại với chủ đề về những thuật toán phân loại trong Data mining, lần này chúng tôi và các bạn sẽ tìm hiểu về Decision Tree, thuật toán có thể nói là “nổi tiếng”, “phổ biến” mà bất kỳ ai hoạt động và làm việc trong lĩnh vực khoa học dữ liệu, hoặc phân tích dữ liệu đều phải biết đến.

Xem thêm: THUẬT TOÁN CÂY QUYẾT ĐỊNH (P.1) : CLASSIFICATION & REGRESSION TREE (CART)

Data visualization tạm được dịch là trực quan hóa dữ liệu, đây là phương pháp không chỉ là bước quan trọng của bất kỳ quy trình phân tích, hay khai phá dữ liệu mà nó còn là công cụ được sử dụng phổ biến và rộng rãi ở mọi tổ chức thuộc mọi lĩnh vực, hay bởi mỗi một ai trong chúng ta, với mục đích đơn giản là truyền đạt, trình bày một cách hiệu quả, đơn giản, thu hút những thông tin, dữ liệu đến người đọc, người xem.

Xem thêm: TỔNG QUAN VỀ DATA VISUALIZATION (TRỰC QUAN HÓA DỮ LIỆU)

TTCT - College Board, tổ chức phi lợi nhuận đang phụ trách kỳ thi SAT, đã bán mỗi cái tên thí sinh kèm theo các thông tin liên quan với giá 47 cent (khoảng 11.000 đồng), gây ra những tranh cãi dữ dội về tuyển sinh đại học ở Mỹ.

|

| Ảnh: Chronicle.com |

Xem thêm: Bán 47 cent /01 tên thí sinh thi SAT: Áp lực khoa cử kiểu Mỹ

Dữ liệu lớn (big data) là một trong những công nghệ mới quan trọng nhất mà ngành du lịch khách sạn cần nắm bắt.

Các ngành công nghiệp khác đã sử dụng dữ liệu lớn và gặt hái được một số thành công đáng kể. Bao gồm khả năng đưa ra quyết định chính xác, nhờ tìm hiểu về khách hàng, đối thủ cạnh tranh, cải thiện trải nghiệm khách hàng và tăng doanh thu. Trong bài viết này, bạn sẽ tìm hiểu thêm về dữ liệu lớn và cách nó có thể đem lại lợi ích cho các công ty du lịch và khách sạn.

Xem thêm: 5 lợi ích dữ liệu lớn (Big data) đem lại cho ngành du lịch khách sạn

Big data trong ngành du lịch đang bùng nổ trong những năm gần đây. Nhiều người cho rằng Big Data sẽ lấy đi sự cá nhân hóa của các doanh nghiệp du lịch, nhưng điều này không hề đúng bởi công nghệ du lịch đã phát triển và Big Data đang được sử dụng để đưa thêm nhiều sự liên hệ cá nhân vào trải nghiệm khách hàng. Vậy Big Data là gì và nó được sử dụng như thế nào trong ngành du lịch? Hãy cùng tìm hiểu trong bài viết dưới đây.

Xem thêm: Từ BIG DATA đến cá nhân hóa trong lĩnh vực du lịch

Nếu các bạn có theo dõi những bài viết của chúng tôi về Data management (quản lý dữ liệu) và Data quality (chất lượng dữ liệu), thì chắc cũng biết tầm quan trọng của quá trình Data security; sự ra đời của những bộ luật, điều luật về bảo mật thông tin, dữ liệu như GDPR tại châu Âu, luật An ninh Mạng ở nước ta; đặc biệt là xu hướng khách hàng đang ngày càng quan tâm hơn về tính minh bạch trong việc sử dụng, và khả năng bảo vệ nguồn dữ liệu, thông tin cá nhân của họ tại các công ty.

Như đã giới thiệu ở bài viết trước “Big Data – thành quả của cách mạng công nghệ 4.0” về nguồn gốc của Big Data, ở bài viết này chúng ta sẽ bàn luận sâu hơn về khái niệm Big Data.

Hàng ngày, chúng ta thường xuyên kết nối thông qua điện thoại, máy tính bảng, bảng điều khiển trò chơi và hầu hết các ứng dụng, các kênh kết nối đều được thực hiện qua các thiết bị này.Khi di chuyển giữa các thiết bị và kênh, họ đang tạo ra nhiều điểm tiếp xúc, kết nối giữa các thiết bị khác nhau mà không hề hay biết.

Xem thêm: BIG DATA Là Chìa Khóa Thành Công Của Marketing Thời Đại Số

Vấn đề là Bộ y tế, cơ quan Bảo hiểm xã hội nên sử dụng quyền hạn của mình như thế nào để yêu cầu các bệnh viện cùng tham gia vào chiến lược xây dựng hệ thống Big Data một cách đồng bộ.

Xem thêm: Dữ liệu lớn góp phần tăng giá trị lớn cho ngành chăm sóc sức khỏe

Ở thời điểm nay, không phải tài sản vật chất, thiết bị máy móc hay cơ sở hạ tầng sản phẩm là tài sản lớn nhất của một doanh nghiệp, mà chính là khách hàng. Nếu bạn không thể làm hài lòng khách hàng và hiểu nhu cầu của họ, thì bạn sẽ không bao giờ trở thành chủ sở hữu của một doanh nghiệp thành công.

Xem thêm: Giải pháp Big data cho lĩnh vực Dịch Vụ Khách Hàng

Big Data có thể tạo ra các phương pháp tiếp cận dựa trên dữ liệu sáng tạo để dạy học sinh. Ở nhiều nước, việc ứng dụng Big Data trong trường học và cao đẳng đã dần trở nên phổ biến. Nhưng các nước đang phát triển cũng bắt đầu nghiên cứu để ứng dụng trong các hoạt động giảng dạy.

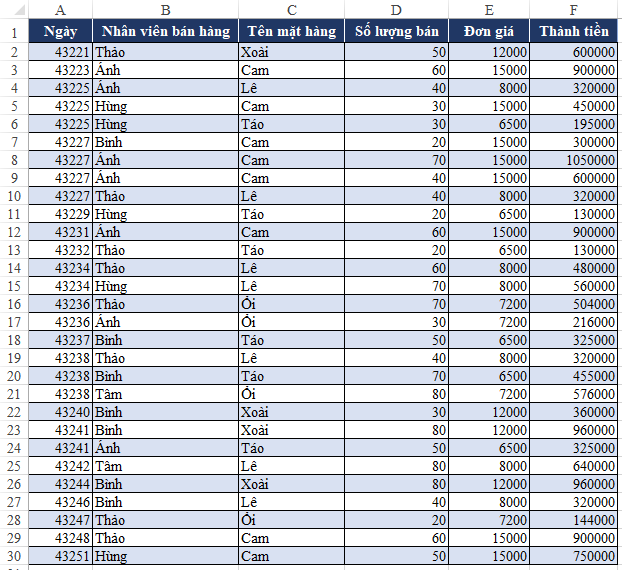

Phân tích dữ liệu là một công việc rất quan trọng giúp chúng ta có thể lập báo cáo tốt hơn, tránh được những sai sót, đảm bảo được tính chính xác của báo cáo. Vậy phân tích dữ liệu là phải làm những công việc gì? Sau đây chúng ta sẽ tìm hiểu về kỹ năng phân tích dữ liệu trước khi lập báo cáo trên Excel thông qua 1 bài tập sau:

Giả sử rằng bạn làm ở vị trí trưởng bộ phận bán hàng. Cuối tháng bạn nhận được 1 bảng dữ liệu về bán hàng trong tháng của cửa hàng mình như sau:

Xem thêm: Tìm hiểu kỹ năng phân tích dữ liệu trước khi lập báo cáo trên Excel

Sự phát triển của ngành ngân hàng (Banking) đi đôi với sự ra đời của Big Data

Ngành ngân hàng đã phát triển theo bước nhảy vọt trong thập kỷ qua từ hoạt động vận hành kinh doanh đến cung cấp dịch vụ. Điều đáng ngạc nhiên chính là, hầu hết các ngân hàng đều gặp khó khăn hay thất bại trong việc sử dụng, khai thác thông tin, dữ liệu từ cơ sở dữ liệu (database) mà họ có được từ khách hàng và từ các chi nhánh, bộ phận của tổ chức.

Xem thêm: ỨNG DỤNG CỦA BIG DATA TRONG LĨNH VỰC NGÂN HÀNG (PHẦN 1)

Ứng dụng Big Data trong ngành truyền thông và giải trí là cả một nghệ thuật. Khoa học và nghệ thuật là hai lĩnh vực trái ngược. Nhưng Big Data và nghệ thuật lại bổ sung cho nhau khá tốt. Ngành truyền thông và giải trí đã chứng kiến một sự thay đổi lớn thông qua liên kết với phân tích Big Data.

Xem thêm: Ứng dụng Big Data trong ngành truyền thông và giải trí

Trở lại với chủ đề bài viết về thuật toán cây quyết định, ở bài viết trước đã giới thiệu đến các bạn tổng quan thế nào là Decision Tree, các công thức quan trọng để xác định cách phân nhánh tối ưu hay nói cách khác là đem lại kết quả phân loại (classification) chính xác dựa trên các thuộc tính dữ liệu và đặc biệt là thuật toán CART (classification and regression tree) sử dụng công thức “Goodness of Split”.

Xem thêm: THUẬT TOÁN CÂY QUYẾT ĐỊNH (P.2): CART (GINI INDEX)

* Mã số Karaoke Việt Nam Arirang 5 số, California 6 số, MusicCore, Sơn Ca Media và Việt KTV bao gồm cả tiếng Việt và tiếng Anh.

* Đầu karaoke Arirang cập nhật đến vol 64 mới nhất.

* Đầu karaoke MusicCore cập nhật đến vol 93 mới nhất.

* Đầu karaoke Sơn Ca Media (ACNOS) cập nhật đến vol 58 mới nhất.

* Đầu karaoke Việt KTV cập nhật đến vol 95 mới nhất.

* Đầu karaoke California cập nhật đến vol 20 mới nhất.

* Tra cứu theo Album Volume...

* Đặc biệt hỗ trợ đầy đủ lời bài hát.

Ở các bài viết trước, chúng tôi đã giới thiệu về khái niệm Chatbot và cách thức vận hành cũng như những phương pháp áp dụng cho quá trình phát triển Chatbot. Ở bài viết lần này, chúng tôi sẽ trình bày các lợi ích của Chatbot đem lại cho khách hàng và các công ty hoạt động kinh doanh.

Xem thêm: TỔNG QUAN VỀ CHATBOT (PHẦN 3): LỢI ÍCH CỦA CHATBOT

Chắc bạn đã một lần từng nghe, hoặc biết đến Chatbot khi đã vô tình bắt gặp nó được thể hiện ở các trang mạng xã hội (social media platform) hay trên các ứng dụng mua sắm trực tuyến (online shopping application). Chatbot hiện đang là công cụ hỗ trợ đắc lực dành cho các công ty, tổ chức trong việc phát triển, duy trì và cải thiện mối quan hệ với khách hàng (customer relationship management).

1. Xu hướng nghề nghiệp trong tương lai

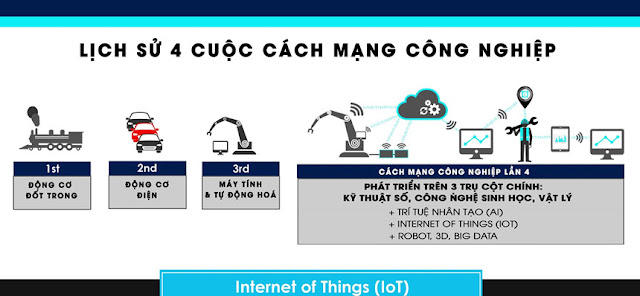

Hiện tại, chúng ta đang sống trong giai đoạn đầu của thời kỳ cách mạng công nghiệp lần thứ 4. Triết lý của cuộc cách mạng công nghiệp 4.0 là chúng ta phải sử dụng công nghệ thông tin để tăng được năng suất lao động, từ đó tiết kiệm được chi phí, mang lại lợi ích cho người tiêu dùng.

Xem thêm: CHUYÊN GIA PHÂN TÍCH DỮ LIỆU – SỰ THÀNH CÔNG TRONG TƯƠNG LAI

Dữ liệu lớn có ở rất nhiều tổ chức, nhiều hoạt động xã hội, kinh doanh, khoa học và tiềm ẩn nhiều giá trị to lớn. Việc đó đồng nghĩa với các nhà khoa học phải đau đầu khi đối phó với việc lưu trữ, xử lý khối lượng số liệu khổng lồ và đa dạng về chủng loại dữ liệu.

Trở lại với chủ đề về thống kê, ở phần trước chúng tôi đã giới thiệu đến các bạn các khái niệm về thống kê cũng như lợi ích và ứng dụng của nó, tiếp theo ở phần này, chúng tôi sẽ đề cập đến một mảng kiến thức quan trọng khác đó chính Descriptive statistics (thống kê mô tả)

Xem thêm: TỔNG QUAN VỀ STATISTICS: DESCRIPTIVE STATISTICS (THỐNG KÊ MÔ TẢ)

Theo một báo cáo mới được công bố tại Diễn đàn Kinh tế Thế giới, những thay đổi về nhân khẩu học và tiến bộ kỹ thuật có thể dẫn đến việc 5 triệu việc làm sẽ biến mất vào năm 2020. Tuy nhiên, ngược lại có một số công việc lại được dự đoán sẽ có sự tăng trưởng đáng kể, trong đó có nghề phân tích dữ liệu.

Chủ đề về Big Data tác động đến social media marketing (tiếp thị qua mạng xã hội), mà cung cấp đến các bạn sẽ được chia thành 2 phần

Xem thêm: SỰ “BÙNG NỔ” CỦA SOCIAL MEDIA VÀ XU HƯỚNG MARKETING MỚI

Ở bài viết trước, phần 1 về ứng dụng Big Data trong lĩnh vực E-commerce, đã giới thiệu đến các bạn tổng quan về thị trường E-commerce, các định nghĩa, khái niệm về kinh doanh trực tuyến, đồng thời mô tả nguồn dữ liệu E-commerce có những đặc tính được coi là Big Data và nói lên nhu cầu khai thác.

Xem thêm: ỨNG DỤNG BIG DATA TRONG LĨNH VỰC E-COMMERCE (PHẦN 2)

Hacker tối qua đã tung thông tin nghi là của hai triệu khách hàng từ một ngân hàng Việt Nam lên Raidforums, một website chuyên mua bán dữ liệu.

Các thông tin bị rò rỉ bao gồm tên đầy đủ, số chứng minh thư, số điện thoại, địa chỉ nhà, ngày tháng năm sinh, giới tính, email và nghề nghiệp.

Để thành công và phát triển, một công ty cần phải có khả năng đạt được, giữ chân, thỏa mãn và thu hút càng nhiều khách hàng càng tốt. Hiểu rõ hơn về khách hàng thông qua phân tích dữ liệu khách hàng vừa là công việc, nhiệm vụ rất quan trọng vừa là cơ sở để đánh giá công ty hoạt động hiệu quả như thế nào.

Xem thêm: TỔNG QUAN VỀ CUSTOMER DATA (P.2) LỢI ÍCH CỦA DỮ LIỆU KHÁCH HÀNG

Nếu các bạn đã theo dõi các bài viết của Big Data Uni thì chắc cũng đã nắm được tổng quan về Big Data bao gồm khái niệm, lợi ích và ứng dụng của nó trong nhiều lĩnh vực khác nhau. Trong chủ đề bài viết lần này và sắp tới, chúng tôi sẽ không đề cập về những giá trị mà Big Data đem lại mà đi vào trọng tâm một trong những công cụ, quá trình quan trọng nhất đối với mỗi dự án Big Data đó chính là Data mining (hay còn gọi là khai phá dữ liệu).

Xem thêm: TỔNG QUAN VỀ DATA MINING (P1): KHAI PHÁ DỮ LIỆU LÀ GÌ?

Mời quý vị tham khảo hồ sơ năng lực của DVMS tại đây >>

Head Office: 95/2/26 Bình Lợi, Phường 13, Q. Bình Thạnh, TP.HCM, Việt Nam.

Tel: 02836028937

Email: sale@dvms.vn

BạnCầnGìCứHỏiDVMS: Chuyển đổi số giao thông, vận tải, giao nhận thông minh ; Giải pháp Blockchain ; Tư vấn, xây dựng, chuyển giao mạng xã hội ; Dịch vụ dữ liệu, Big data ; Uber Giúp việc, uber dịch vụ tại nhà ; Chuyển đổi số cho bệnh viện, y tế ; Chuyển đổi số Bác sĩ gia đình, y tế tại nhà ; Chuyển đổi số cho công ty tín dụng, ngân hàng, Fintech ; Chuyển đổi số cho công ty bảo hiểm ; Chuyển đổi số bán hàng, quản lý hệ thống phân phối ; Chuyển đổi số lĩnh vực du lịch; Chuyển đổi số lĩnh xăng dầu, gas; Giải pháp OTT; Chuyển đổi số nhà thuốc và công ty dược; Chuyển đổi số doanh nghiệp taxi; Chuyển đổi số doanh nghiệp vận tải; Chuyển đổi số dịch vụ tại nhà; Chuyển đổi số nông nghiệp; Giải pháp QRCODE ; Đào tạo chuyển đổi số, xây dựng đội ngũ CNTT cho doanh nghiệp và start-up; Giải pháp chăm sóc sức khỏe tại nhà ; ứng dụng định vị vệ tinh vào cuộc sống;Giải pháp truyền hình; thực tế ảo; mobile game; và giải pháp cho nhiều lĩnh vực khác